Impactos ocultos

19 de Junio de 2025

IA generativa: la degradación del pensamiento científico, la educación y el pensamiento crítico

Escriben Gustavo Archuby, de la Facultad de Humanidades y Cs. de la Educación UNLP, y Gabriel Baum, del LIFIA, Facultad de Informática UNLP.

Escriben Gustavo Archuby, de la Facultad de Humanidades y Cs. de la Educación UNLP, y Gabriel Baum, del LIFIA, Facultad de Informática UNLP.

Las plataformas de inteligencia artificial (IA) que se han popularizado — como ChatGPT, Gemini o Copilot—y que son de uso extendido por ser versiones que ofrecen las empresas, donde, por el momento, se paga, pero no con dinero, prometen acceso instantáneo a cualquier conocimiento. Bastan unas pocas palabras para obtener textos, respuestas, resúmenes o ideas. Sin embargo, detrás de esa comodidad se esconde una transformación profunda y silenciosa: estas herramientas están cambiando las reglas del juego en la forma en que se produce y comparte el conocimiento.

Las plataformas de inteligencia artificial (IA) que se han popularizado — como ChatGPT, Gemini o Copilot—y que son de uso extendido por ser versiones que ofrecen las empresas, donde, por el momento, se paga, pero no con dinero, prometen acceso instantáneo a cualquier conocimiento. Bastan unas pocas palabras para obtener textos, respuestas, resúmenes o ideas. Sin embargo, detrás de esa comodidad se esconde una transformación profunda y silenciosa: estas herramientas están cambiando las reglas del juego en la forma en que se produce y comparte el conocimiento.

Lo que a primera vista parece una revolución positiva, es en realidad un movimiento que amenaza con debilitar —e incluso vaciar— algunos espacios donde el conocimiento se construye colectivamente: comunidades colaborativas, repositorios académicos, foros técnicos y enciclopedias abiertas. ¿Qué sucede cuando usamos una IA para resolver un problema, pero dejamos de contribuir al foro que solía tener esa respuesta? ¿Quién gana, quién pierde y qué queda en pie?

Gustavo Archuby, de la Facultad de Humanidades y Cs. de la Educación UNLP, y Gabriel Baum, del LIFIA, Facultad de Informática UNLP

Las plataformas de IA funcionan gracias a enormes cantidades de datos generados por comunidades abiertas y colaborativas. Wikipedia, Stack Overflow, repositorios institucionales, foros científicos: todos ellos fueron utilizados para entrenar a los modelos de lenguaje que hoy responden en segundos lo que antes llevaba mucho más tiempo buscar. Pero aquí surge la paradoja: cuanto más usamos las IA, menos alimentamos a esas fuentes.

Tal como dice Nature en su edición del 2 de junio pasado: "Los bots de IA que extraen datos web causan disrupción en las bases de datos y revistas científicas. Los programas automatizados que recopilan datos de entrenamiento para herramientas de inteligencia artificial están saturando los sitios web académicos".

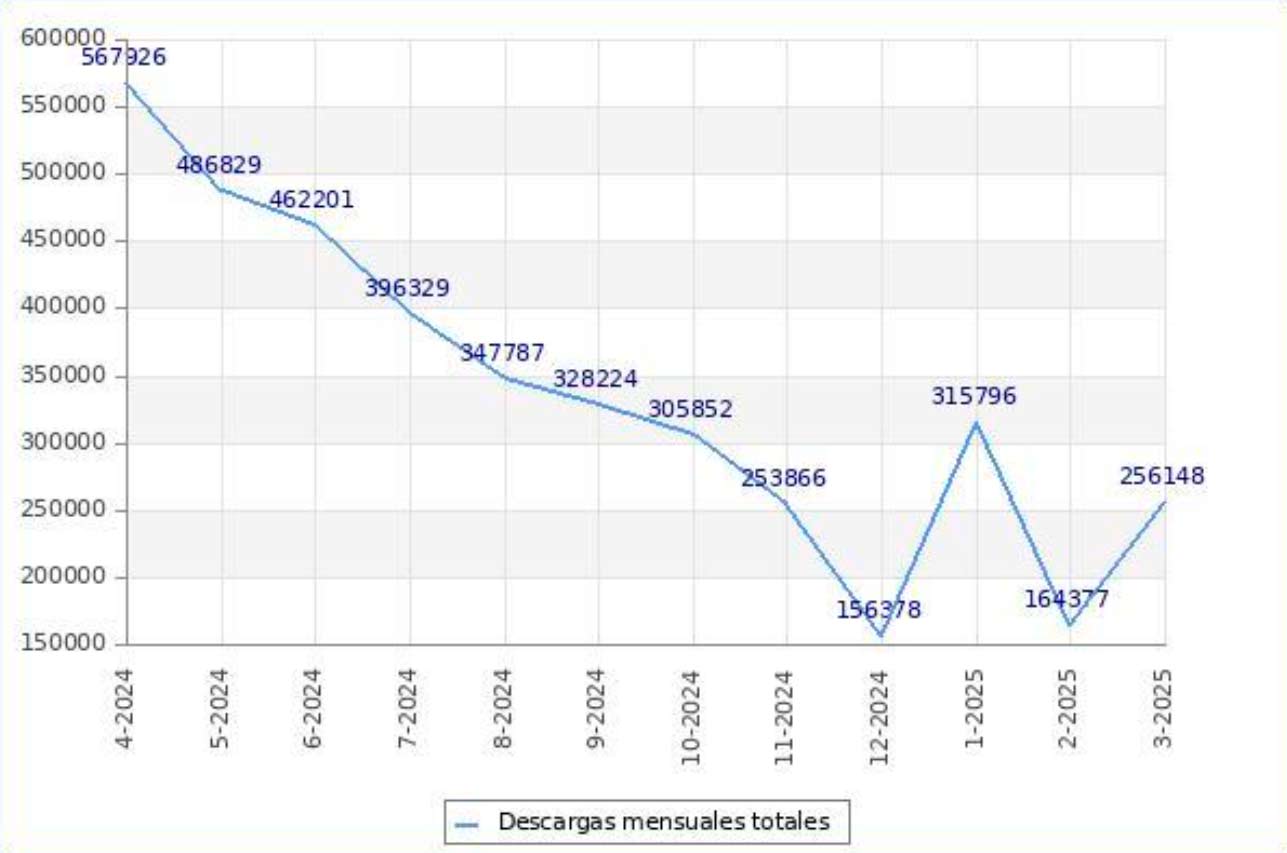

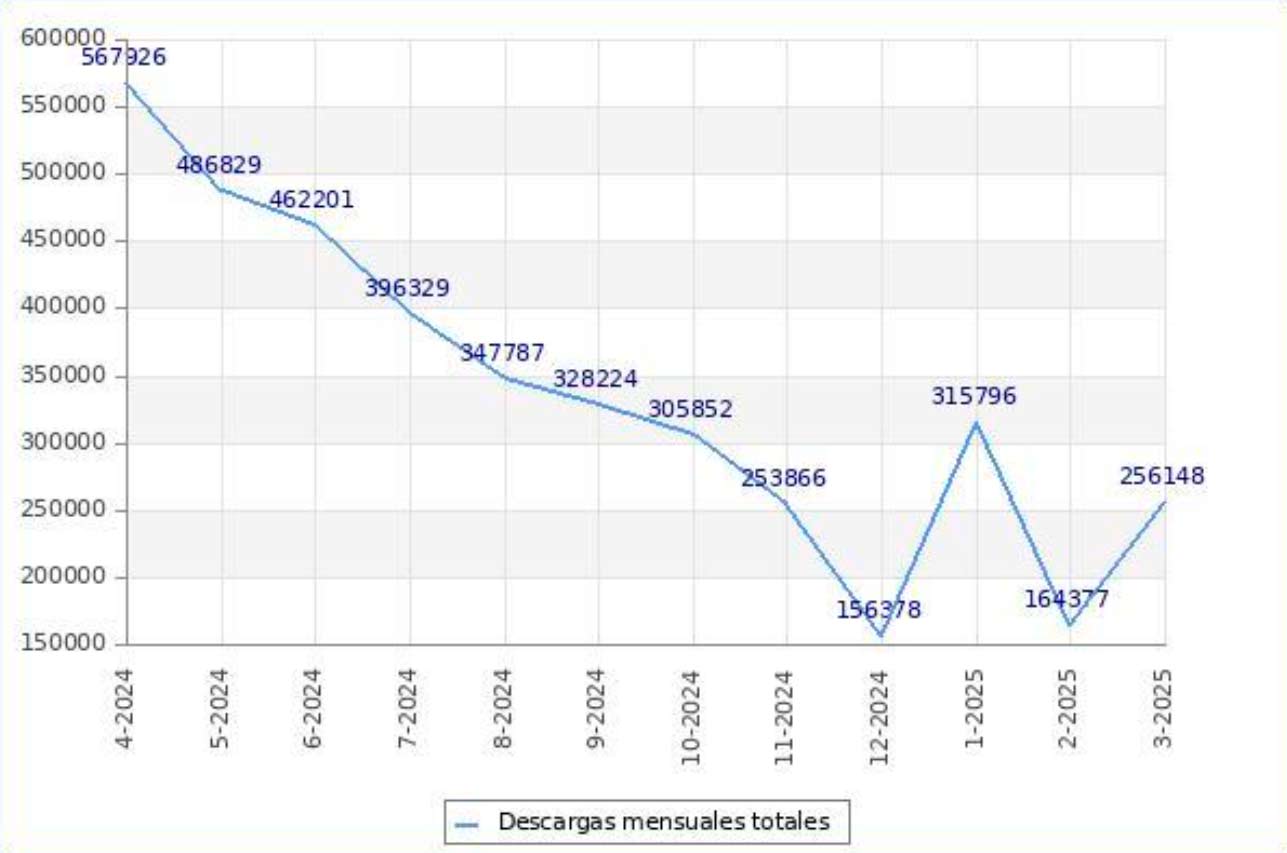

En el ámbito local también se registra el mismo fenómeno de saqueo y pérdida de volumen de los ámbitos colaborativos. Un proyecto de varias instituciones académicas argentinas da cuenta de ello. El siguiente gráfico muestra claramente la caída en los accesos a una fuente universitaria de alto impacto en Argentina: el Repositorio Institucional Memoria Académica Facultad de Humanidades UNLP.

El “pico” en el 1° cuatrimestre de 2025 se debe a una caída del firewall que impide el acceso de los bots

Las comunidades pierden usuarios, caen sus contribuciones, disminuye su visibilidad y en muchos casos también su financiamiento. Si este ciclo continúa, no solo desaparecen esos espacios, sino que también se seca la fuente que da vida a las propias plataformas de IA.

La IA no “sabe” en el sentido humano: reorganiza datos previos y predice respuestas plausibles. No crea conocimiento nuevo, sino que lo simula extrayendo información de los miles de millones de textos con que fue entrenada. Pero lo hace sin dar crédito a quienes lo produjeron. Extraen información de documentos académicos, tesis y artículos disponibles en repositorios abiertos sin citar autores ni respetar condiciones básicas de uso. Esto no es solo una cuestión ética: implica que el esfuerzo público para generar conocimiento se convierte en insumo gratuito para mega-empresas privadas globales.

A su vez, al recibir respuestas ya formuladas y empaquetadas, las personas dejan de participar en procesos de discusión, mejora y validación colectiva. El conocimiento se vuelve algo cerrado, sin comunidad, sin debate, sin historia.

Otro efecto preocupante es la erosión del pensamiento crítico. Las respuestas generadas por IA suelen presentarse como “correctas”, sin margen para la duda o el contraste, también llamado “sesgo de automatización” o “sesgo de autoridad tecnológica”. Si los usuarios aceptan sin cuestionar lo que les dice la máquina, se reduce su capacidad de análisis, de resolución de problemas y de aprendizaje. Esta situación se vuelve especialmente delicada cuando las herramientas se usan en contextos educativos o científicos, donde el error, el contraste y la discusión son parte fundamental del proceso.

Además, la dependencia creciente de estas plataformas puede volvernos más pasivos: si la IA no tiene una respuesta lista, ¿quién va a buscarla por otros medios?

Los modelos de IA están entrenados con información disponible en Internet, pero no toda la información tiene el mismo peso. Las voces del sur global, de las minorías culturales o de comunidades marginadas están subrepresentadas. Esto significa que las respuestas que obtenemos tienden a reproducir una visión dominante, muchas veces occidental, homogemónica y, por ende, sesgada[1].

Por otro lado, el uso de estas herramientas en la toma de decisiones en ámbitos sociales como la educación, la justicia o el acceso a beneficios sociales, puede representar un serio problema. Estas tecnologías operan a partir de datos y normativas existentes hasta el momento de su entrenamiento, lo que significa que sus decisiones estarán necesariamente condicionadas por las reglas y valores del orden establecido. En lugar de cuestionarlos, tienden a reproducirlos, contribuyendo a la perpetuación de desigualdades sociales y dificultando los procesos de transformación, por lo general, llevados a cabo por minorías que luchan por sus derechos. Un ejemplo ilustrativo puede encontrarse en la evolución legal del femicidio en Uruguay: en 1920, un hombre tenía el derecho de asesinar a su esposa si la encontraba con otro hombre; menos de un siglo después, ese acto pasó a considerarse un homicidio, luego un homicidio calificado, hasta alcanzar su actual tipificación como femicidio. Un modelo de lenguaje entrenado con datos y leyes de 1920 no solo habría legitimado esa violencia, sino que habría dificultado el impulso de los cambios necesarios, reforzando normativas que hoy reconocemos como profundamente injustas.

No se trata de demonizar las plataformas de IA: ya son parte del presente. Pero aceptarlas sin discusión es renunciar a nuestras propias formas de construir conocimiento. Como sociedad, podemos:

No es conveniente ni razonable delegar actividades críticas en la generación y transmisión de conocimientos en plataformas diseñadas para el lucro. Necesitamos herramientas al servicio del aprendizaje, la colaboración y la diversidad. Tenemos la capacidad y los recursos humanos para pensar, crear y compartir de otra forma.

En lugar de esperar que las soluciones lleguen de la mano de corporaciones apátridas, debemos ejercer la soberanía partir de la construcción de alternativas públicas, recuperar el ejercicio de la "inteligencia" a partir de un uso ético basado en una pedagogía sobre usos posibles. Conocer como funcionan, como se componen para desmitificarlas y saber que no podemos delegar en una máquina las decisiones que nos afectan.

Los autores agradecen especialmente el valioso aporte de los investigadores Marcela Fushimi(UNLP), Horacio Degiorgi (UNCuyo), Adrián Méndez (UNCuyo), Diego Ferreyra (UBA).

Gustavo Archuby, de la Facultad de Humanidades y Cs. de la Educación UNLP, y Gabriel Baum, del LIFIA, Facultad de Informática UNLP

La paradoja de las respuestas instantáneas

Las plataformas de IA funcionan gracias a enormes cantidades de datos generados por comunidades abiertas y colaborativas. Wikipedia, Stack Overflow, repositorios institucionales, foros científicos: todos ellos fueron utilizados para entrenar a los modelos de lenguaje que hoy responden en segundos lo que antes llevaba mucho más tiempo buscar. Pero aquí surge la paradoja: cuanto más usamos las IA, menos alimentamos a esas fuentes.

Tal como dice Nature en su edición del 2 de junio pasado: "Los bots de IA que extraen datos web causan disrupción en las bases de datos y revistas científicas. Los programas automatizados que recopilan datos de entrenamiento para herramientas de inteligencia artificial están saturando los sitios web académicos".

En el ámbito local también se registra el mismo fenómeno de saqueo y pérdida de volumen de los ámbitos colaborativos. Un proyecto de varias instituciones académicas argentinas da cuenta de ello. El siguiente gráfico muestra claramente la caída en los accesos a una fuente universitaria de alto impacto en Argentina: el Repositorio Institucional Memoria Académica Facultad de Humanidades UNLP.

El “pico” en el 1° cuatrimestre de 2025 se debe a una caída del firewall que impide el acceso de los bots

Las comunidades pierden usuarios, caen sus contribuciones, disminuye su visibilidad y en muchos casos también su financiamiento. Si este ciclo continúa, no solo desaparecen esos espacios, sino que también se seca la fuente que da vida a las propias plataformas de IA.

¿De quién es el conocimiento?

La IA no “sabe” en el sentido humano: reorganiza datos previos y predice respuestas plausibles. No crea conocimiento nuevo, sino que lo simula extrayendo información de los miles de millones de textos con que fue entrenada. Pero lo hace sin dar crédito a quienes lo produjeron. Extraen información de documentos académicos, tesis y artículos disponibles en repositorios abiertos sin citar autores ni respetar condiciones básicas de uso. Esto no es solo una cuestión ética: implica que el esfuerzo público para generar conocimiento se convierte en insumo gratuito para mega-empresas privadas globales.

A su vez, al recibir respuestas ya formuladas y empaquetadas, las personas dejan de participar en procesos de discusión, mejora y validación colectiva. El conocimiento se vuelve algo cerrado, sin comunidad, sin debate, sin historia.

Pensamiento crítico en peligro

Otro efecto preocupante es la erosión del pensamiento crítico. Las respuestas generadas por IA suelen presentarse como “correctas”, sin margen para la duda o el contraste, también llamado “sesgo de automatización” o “sesgo de autoridad tecnológica”. Si los usuarios aceptan sin cuestionar lo que les dice la máquina, se reduce su capacidad de análisis, de resolución de problemas y de aprendizaje. Esta situación se vuelve especialmente delicada cuando las herramientas se usan en contextos educativos o científicos, donde el error, el contraste y la discusión son parte fundamental del proceso.

Además, la dependencia creciente de estas plataformas puede volvernos más pasivos: si la IA no tiene una respuesta lista, ¿quién va a buscarla por otros medios?

Lo que no se nombra: sesgos, exclusiones y desigualdades

Los modelos de IA están entrenados con información disponible en Internet, pero no toda la información tiene el mismo peso. Las voces del sur global, de las minorías culturales o de comunidades marginadas están subrepresentadas. Esto significa que las respuestas que obtenemos tienden a reproducir una visión dominante, muchas veces occidental, homogemónica y, por ende, sesgada[1].

Por otro lado, el uso de estas herramientas en la toma de decisiones en ámbitos sociales como la educación, la justicia o el acceso a beneficios sociales, puede representar un serio problema. Estas tecnologías operan a partir de datos y normativas existentes hasta el momento de su entrenamiento, lo que significa que sus decisiones estarán necesariamente condicionadas por las reglas y valores del orden establecido. En lugar de cuestionarlos, tienden a reproducirlos, contribuyendo a la perpetuación de desigualdades sociales y dificultando los procesos de transformación, por lo general, llevados a cabo por minorías que luchan por sus derechos. Un ejemplo ilustrativo puede encontrarse en la evolución legal del femicidio en Uruguay: en 1920, un hombre tenía el derecho de asesinar a su esposa si la encontraba con otro hombre; menos de un siglo después, ese acto pasó a considerarse un homicidio, luego un homicidio calificado, hasta alcanzar su actual tipificación como femicidio. Un modelo de lenguaje entrenado con datos y leyes de 1920 no solo habría legitimado esa violencia, sino que habría dificultado el impulso de los cambios necesarios, reforzando normativas que hoy reconocemos como profundamente injustas.

¿Hay alternativas?

No se trata de demonizar las plataformas de IA: ya son parte del presente. Pero aceptarlas sin discusión es renunciar a nuestras propias formas de construir conocimiento. Como sociedad, podemos:

- Regular su acceso a repositorios públicos, para que respeten derechos de autor y condiciones de uso.

- Desarrollar nuestras propias plataformas, con fines educativos, científicos o sociales, y no solo económicos.

- Fomentar la participación en comunidades abiertas, explicando su importancia y reconociendo su valor.

- Educar en pensamiento crítico, para que las nuevas generaciones no confundan respuestas automáticas con conocimiento verdadero.

Epílogo: que no nos usen, usemos nosotros

No es conveniente ni razonable delegar actividades críticas en la generación y transmisión de conocimientos en plataformas diseñadas para el lucro. Necesitamos herramientas al servicio del aprendizaje, la colaboración y la diversidad. Tenemos la capacidad y los recursos humanos para pensar, crear y compartir de otra forma.

En lugar de esperar que las soluciones lleguen de la mano de corporaciones apátridas, debemos ejercer la soberanía partir de la construcción de alternativas públicas, recuperar el ejercicio de la "inteligencia" a partir de un uso ético basado en una pedagogía sobre usos posibles. Conocer como funcionan, como se componen para desmitificarlas y saber que no podemos delegar en una máquina las decisiones que nos afectan.

Los autores agradecen especialmente el valioso aporte de los investigadores Marcela Fushimi(UNLP), Horacio Degiorgi (UNCuyo), Adrián Méndez (UNCuyo), Diego Ferreyra (UBA).

[1] Ver por ejemplo: [Mohamed et al 2020] Shakir Mohamed, Marie-Therese Png, William Isaac. Decolonial AI: Decolonial Theory as Sociotechnical Foresight in Artificial Intelligence. Philosophy & Technology volume 33, pages659–684 (2020).

[Karen Hao 2022] Karen Hao. Artificial intelligence is creating a new colonial world order. MIT Technology Review, April 19, 2020. (https://www.technologyreview.com/2022/04/19/1049592/artificial-intelligence-colonialism/). Volver arriba.

- Otras Noticias

Malabia 1720 11b (Areatres) C1414DMJ

Capital Federal - Buenos Aires - Argentina

TE / FAX: (54-11) 5199-6274

© CanalLA | Publicidad

Desarrollado por: Tekmerion

América Latina

América Latina Argentina

Argentina Chile

Chile Colombia

Colombia México

México Uruguay

Uruguay